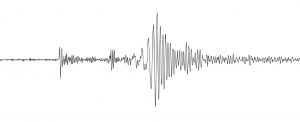

Magnituden gelten als Maß für die Stärke von Erdbeben und werden meistens aus den Maximalamplituden von Seismogrammen ermittelt. Diese Amplituden werden in einem linearen Zusammenhang mit der Energiefreisetzung gebracht, wodurch die Stärke verschiedener Erdbeben vergleichbar wird.

Magnituden gelten als Maß für die Stärke von Erdbeben und werden meistens aus den Maximalamplituden von Seismogrammen ermittelt. Diese Amplituden werden in einem linearen Zusammenhang mit der Energiefreisetzung gebracht, wodurch die Stärke verschiedener Erdbeben vergleichbar wird.

Es gibt eine Vielzahl unterschiedlicher Magnituden-Skalen, die allerdings untereinander schwer zu vergleichen sind:

Richterskala

Am bekanntesten ist die Richterskala, die heute kaum noch benutzt wird. Sie wurde in den 1930iger Jahren von Charles Richter entwickelt und wird wissenschaftlich als Lokalbebenmagnitude (ML) bezeichnet. Sie eignet sich nur für Erdbeben bei denen der Abstand zwischen dem Erdbebenzentrum (Epizentrum) und dem Seismographen kleiner als 1000 km ist.

Die Richterskala stellt eine logarithmische Beziehung zwischen dem Abklingverhalten einer seismischen Welle und deren Stärke her. Als Grundlage für diese Funktion dient die Beobachtung, dass es einen Zusammenhang zwischen dem maximalen Ausschlag eines Seismogramms und der Entfernung zum Epizentrum gibt. Richter stellte den dekadischen Logarithmus der Amplitudenwerte als Funktion vom Abstand des Messinstruments zum Epizentrum dar. Eine Erhöhung um eine Magnitude entspricht einer Verzehnfachung der Amplitude.

Für die Darstellung von Erdbeben mit Magnituden größer 6,5 taugt die Richterskala allerdings nichts. Ein Problem der meisten Magnituden-Skalen ist, dass sich die Amplituden im oberen Bereich nur noch wenig erhöhen, wenn mehr Energie freigesetzt wird. Diese Eigenschaft wird als Sättigungsproblem bezeichnet.

Oberflächenwellen-Magnitude

Die Energie eines Erdbebens lässt sich am besten berechnen, wenn man die Oberflächenwellen-Magnitude (Ms) betrachtet und sie in einer logarithmischen Funktion verwendet. Kernaussage dieser Funktion ist, dass bei der Erhöhung der Magnitude um eine Stufe das 32-fache an Energie frei wird. Bei einer Erhöhung um 2 Magnituden wird bereits mehr als 1000 Mal soviel Energie frei.

Moment-Magnituden-Skala

Um das Sättigungsproblem zu umgehen wurde die Moment-Magnituden-Skala (Mw) entwickelt. Sie ist heute quasi Standard und wird oft unwissentlich verwendet, wenn in den Medien von der Richterskala die Rede ist. Die Mw-Skala wurde 1977 von Kanamori eingeführt und basiert auf dem Seismischen Moment (Mo). Dies ist ein Skalarprodukt aus der Größe der Bruchfläche im Untergrund, der mittleren Verschiebung der Gesteinsblöcke und dem Schermodul des Gesteins. Das Seismische Moment wird mittels einer Formel aus der Oberflächenwellen-Magnitude bestimmt, erfährt aber keine Sättigung im oberen Amplitudenbereich. Daher eignet sich die Mw dazu die Stärken großer Erdbeben zu vergleichen. Die Moment-Magnituden-Skala ist begrenzt. Sie endet bei 10,6. Man nimmt an, dass die feste Erdkruste bei dieser Magnitude komplett zerbricht. Das stärkste jemals gemessene Erdbeben ereignete sich 1960 in Chile. Das Valdivia Erdbeben brachte es auf Mw 9,5 in 33 km Tiefe.

Die Betrachtung der Magnitude alleine reicht allerdings nicht aus um die Schäden eines Erdbebens zu qualifizieren. Man kann zwar abschätzen, dass mögliche Schäden eines energiereichen Erdbebens höher sind, als von einem Schwächeren. Ein entscheidendes Kriterium ist allerdings auch die Tiefe des Erdbebens. Je näher ein Hypozentrum an der Erdoberfläche liegt, desto fataler seine Auswirkungen. Dabei kann es sein, dass ein schwächerer, aber flacher liegender Erdstoß mehr Schaden anrichtet, als ein stärkerer tief liegender Erdstoß. Die Vorschädigung der Bausubstanz ist ebenfalls ein wichtiges Kriterium um mögliche Schäden und Opferzahlen abzuschätzen. Oberflächennahe heißt im Allgemeinen eine Tiefe geringer als 10 km. Erdbeben in Tiefen größer 20 km verlaufen meistens weniger tragisch, es sei denn sie waren sehr stark.

(Quelle: WIKIPEDIA, USGS, GFZ)